Premiers pas avec Procore Analytics 2.0

- Dernière mise à jour

- Enregistrer en tant que PDF

Table des matières

- Connecteur Nuage de Analytique Procore

- Commencer l’installation

- Choisir une méthode de connexion de données

- Se connecter à Power BI Desktop

- Se connecter à SQL Server à l’aide de Python (SSIS)

- Se connecter à SQL Server à l’aide de la bibliothèque Python

- Se connecter à SQL Server à l’aide de Python Spark

- Se connecter à ADLS à l’aide d’Azure Functions

- Se connecter à ADLS à l’aide de Python

- Se connecter à ADLS à l’aide de Spark

- Se connecter à Fabric Lakehouse à l’aide de Data Factory

- Se connecter à Fabric Lakehouse à l’aide de Fabric Notebooks

- Se connecter à SQL Server à l’aide d’Azure Functions

- Se connecter à SQL Server à l’aide de Data Factory

- Se connecter à SQL Server à l’aide de Fabric Notebook

- Se connecter aux Databricks

- Se connecter à Snowflake à l’aide de Python

- Se connecter à Amazon S3 à l’aide de Python

- Construisez votre propre connexion

Connecteur Nuage de Analytique Procore

Préambule

Nuage Connector est la façon dont Procore partage les données, l’intelligence et l’analyse avec nos clients. Ces informations peuvent être partagées directement avec des outils de création de rapports tels que Power BI ou Tableau. Il peut également être partagé avec les entrepôts de données, les magasins, les lacs ou d’autres applications des clients. Les clients peuvent même créer un accès programmatique à leurs données à l’aide de Nuage Connector pour une véritable automatisation. Nuage Connector est basé sur le protocole de partage ouvert Delta Share.

Options du connecteur de données guidées Procore Analytics 2.0

Delta Sharing est le premier protocole ouvert de l’industrie pour le partage sécurisé de données, ce qui facilite le partage de données avec d’autres organisations, quelles que soient les plates-formes informatiques qu’elles utilisent. De nombreuses applications peuvent accéder aux données avec Delta Share. Cependant, pour améliorer encore l’expérience client, Procore a ajouté des connecteurs, du code prédéfini et des guides pour les plates-formes suivantes, réduisant ainsi le temps et la complexité de configuration pour permettre une connexion transparente et prête à l’emploi.

- SQL Server

- SSIS Python

- Bibliothèque Python

- Étincelle Python

- Azure

- ADLS Azure Functions

- ADLS Python

- ADLS Spark

- Usine de données Lakehouse Fabric

- Carnet de notes en tissu Lakehouse

- SQL Server Azure Functions

- Fabrique de données SQL Server Fabric

- Bloc-notes SQL Server Fabric

- Briques de données

- Flocon de neige

- Amazon S3

- Guides pour écrire le vôtre (GitHub)

D’autres connecteurs de données seront bientôt disponibles !

Accéder à la documentation et au code

Une documentation complète et des exemples de code sont disponibles dans le produit Procore Analytics directement dans l’application Web Procore accessible par vos administrateurs Procore. Ces ressources fournissent des instructions pas à pas, des extraits de code et des meilleures pratiques pour vous aider à configurer et à gérer efficacement votre intégration de données.

Étapes suivantes

Passez à la section suivante de ce guide pour commencer le processus d’installation.

Pour toute question supplémentaire ou pour obtenir de l’aide, veuillez contacter votre gestionnaire de compte ou notre équipe d’assistance.

Vérifier les permissions

Remarque

- Vous devez avoir activé l’outil Analytique au niveau de l’entreprise pour le compte Procore de votre entreprise.

- Toute personne disposant d’un accès de niveau « Admin » à l’outil d’analyse peut accorder à des utilisateurs supplémentaires l’accès à l’outil d’analyse.

- Les utilisateurs doivent avoir un accès de niveau « Admin » à l’outil d’analyse pour générer un jeton d’accès.

- Toute modification des permissions d’un utilisateur dans le Répertoire d’analyse prendra jusqu’à 24 heures pour être active.

Vous devez vous assurer que les permissions appropriées sont attribuées pour générer un jeton d’accès afin de pouvoir commencer à connecter vos données Procore à votre solution de BI. L’accès à Analytics est lié à vos identifiants de connexion Procore, ce qui vous permet de générer un seul jeton d’accès. Le jeton d’accès est une chaîne de chiffres que vous saisirez dans votre système de BI pour accéder aux données.

En règle générale, les utilisateurs qui ont besoin de jetons d’accès sont des ingénieurs de données ou des développeurs Power BI. Si vous avez accès à Analytics dans plusieurs compagnies, votre jeton vous permettra d’extraire les données de chacune d’entre elles. Le jeton est lié à vous, et non à une entreprise en particulier, il reste donc le même pour toutes les entreprises auxquelles vous avez accès.

Les administrateurs de la compagnie et du projet se verront accorder un rôle d’administrateur par défaut. Les niveaux d’accès utilisateur suivants sont autorisés pour l’outil Analytique :

- Aucun : Pas d’accès aux données d’Analytics.

- Admin: A des permissions d’accès complètes aux données pour tous les outils et projets (à l’exception de certaines données marquées comme privées, telles que les données de correspondance).

Il existe deux façons d’attribuer des permissions à des utilisateurs individuels :

Révocation de l’accès

L’accès aux données de l’outil Analytique sera révoqué lorsque les permissions d’un utilisateur pour l’outil seront supprimées. De plus, si l’enregistrement de contact d’un utilisateur devient inactif, il perdra également l’accès aux données d’Analytics.

Générer des identifiants d’accès aux données

Pour commencer à accéder à vos données Procore, il existe deux options pour générer vos identifiants d’accès aux données : la méthode de connexion directe Databricks ou la méthode Delta Share Token. Le jeton d’accès est une chaîne de chiffres que vous entrez dans votre connecteur de données applicable pour accéder aux données.

Considérations

- L’outil Analyse Procore doit être activé.

- Par défaut, tous les administrateurs de la compagnie ont un accès de niveau « Admin » aux analyses du répertoire.

- Toute personne disposant d’un accès de niveau « Admin » à Analytics peut accorder à d’autres utilisateurs l’accès à l’outil Analytics.

- Les utilisateurs doivent disposer d’un accès de niveau « Admin » à l’outil Analytics pour générer un jeton de données.

Étapes

- Connectez-vous à Procore.

- Cliquez sur l’icône Compte et profil dans la zone supérieure droite de la barre de navigation.

- Cliquez sur Paramètres de mon profil.

- Sous Choisir votre connexion avec Procore Analytics, vous avez deux options pour générer des informations d’identification :

- Databricks se connecte directement OU génère un jeton d’accès personnel avec Delta Share.

- Entrez votre identificateur de partage Databricks pour la méthode de connexion directe Databricks, puis cliquez sur Se connecter. Pour en savoir plus, consultez Connecter vos données Procore à un espace de travail Databricks.

- Pour la méthode token, sélectionnez Delta Share Token (Jeton de partage Delta).

- Assurez-vous de choisir une date d’expiration.

- Cliquez sur Générer des jetons.

C’est important ! Il est recommandé de copier et de stocker votre jeton pour référence future, car Procore ne stocke pas les jetons pour les utilisateurs. - Vous utiliserez votre jeton de porteur, votre nom de partage, l’URL du serveur de partage Delta et votre version des informations d’identification de partage pour commencer à accéder à vos données et à les intégrer.

- Explorez les sections supplémentaires du Guide de démarrage pour connaître les prochaines étapes à suivre pour connecter vos données en fonction de la méthode de connexion de données souhaitée.

Remarque

- Le jeton disparaîtra au bout d’une heure ou il disparaîtra également si vous quittez la page. Pour générer un nouveau jeton, revenez à l’étape 1.

- Il peut s’écouler jusqu’à 24 heures avant que les données ne deviennent visibles.

- Veuillez ne pas régénérer votre jeton pendant cette période de traitement, car cela pourrait causer des problèmes avec votre jeton.

Téléverser des rapports sur Power BI (le cas échéant)

- Accédez à Procore Analytics à partir du menu Outils de votre compagnie .

- Accédez à la section Mise en route .

- Sous Fichiers Power BI, sélectionnez et téléchargez les rapports Power BI disponibles.

- Connectez-vous au service Power BI à l’aide de vos informations d’identification de connexion Power BI.

- Créez un espace de travail dans lequel vous souhaitez stocker les rapports Procore Analytics de votre compagnie. Pour plus d’informations, consultez la documentation de support Power BI de Microsoft .

Remarques : Des exigences en matière de permis peuvent s’appliquer. - Dans l’espace de travail, cliquez sur Téléverser.

- Cliquez maintenant sur Parcourir.

- Sélectionnez le fichier de rapport à partir de son emplacement sur votre ordinateur et cliquez sur Ouvrir.

- Après avoir téléversé le fichier, cliquez sur Filtre et sélectionnez Modèle sémantique.

- Passez votre curseur sur la ligne portant le nom du rapport et cliquez sur l’icône représentant des points de suspension

verticaux.

verticaux. - Cliquez sur Paramètres.

- Sur la page des paramètres, cliquez sur Identifiants de la source de données , puis sur Modifier les identifiants.

- Dans la fenêtre « Configurer [Nom du rapport] » qui s'affiche, procédez comme suit :

- Méthode d’authentification : Sélectionnez « Clé ».

- Clé de compte: Saisissez le jeton que vous avez reçu de la page de génération de jetons dans Procore.

- Paramètre de niveau de confidentialité pour cette source de données: sélectionnez le niveau de confidentialité. Nous vous recommandons de sélectionner « Privé » ou « Organisationnel ». Voir la documentation de support Power BI de Microsoft pour plus d'informations sur les niveaux de confidentialité.

- Cliquez sur Connexion.

- Cliquez sur Refresh et procédez comme suit :

- Fuseau horaire: sélectionnez le fuseau horaire que vous souhaitez utiliser pour les actualisations de données planifiées.

- Sous Configurer un programme d’actualisation, basculez le bouton en position ON.

- Fréquence d'actualisation: Sélectionnez « Quotidien ».

- Heure: Cliquez sur Ajouter une autre heure et sélectionnez 7 h 00.

Remarque : Vous pouvez ajouter jusqu’à 8 temps d’actualisation. - Facultatif:

- Cochez la case à cocher « Envoyer des notifications d'échec d'actualisation au propriétaire de l'ensemble de données » pour envoyer des notifications d'échec d'actualisation.

- Saisissez les adresses courriel de tous les autres collègues auxquels vous souhaitez que le système envoie les notifications d'échec d'actualisation.

- Cliquez sur Appliquer.

- Pour vérifier que les paramètres ont été configurés correctement et que les données du rapport s'actualiseront correctement, revenez à la page « Filtrer et sélectionner le modèle sémantique » et procédez comme suit :

- Passez votre curseur sur la ligne portant le nom du rapport et cliquez sur l'icône en forme de flèche circulaire pour actualiser les données manuellement.

- Vérifiez la colonne « Actualisé » pour voir s'il y a un avertissement

icône.

icône.

- Si aucune icône d’avertissement ne s’affiche, les données du rapport sont actualisées avec succès.

- Si une icône d'avertissement s'affiche, une erreur s'est produite. Cliquez sur l' avertissement

pour afficher plus d'informations sur l'erreur.

pour afficher plus d'informations sur l'erreur.

- Pour supprimer le tableau de bord vide créé automatiquement par le service Power BI, procédez comme suit :

- Passez votre curseur sur la ligne portant le nom du tableau de bord. Cliquez sur les points de suspension

et cliquez sur Supprimer.

et cliquez sur Supprimer.

- Passez votre curseur sur la ligne portant le nom du tableau de bord. Cliquez sur les points de suspension

- Pour vérifier que le rapport s'affiche correctement, accédez à la page « Tous » ou « Contenu » et cliquez sur le nom du rapport pour afficher le rapport dans le service Power BI.

Conseil

Référencez la colonne « Type » pour vous assurer que vous cliquez sur le rapport au lieu d'un actif différent.

- Répétez les étapes ci-dessus dans Power BI pour chaque fichier de rapport Procore Analytics.

Se connecter à Power BI Desktop

Remarque

Ces méthodes de connexion sont généralement utilisées par les professionnels de la data.Connecter de nouvelles données

- Ouvrez votre bureau Power BI.

- Cliquez sur Obtenir des données et sélectionnez Plus.

- Dans la barre de recherche, tapez « Partage Delta ».

- Sélectionnez Partage delta, puis cliquez sur Se connecter.

- Tapez ou collez l’URL du serveur de partage Delta que vous avez reçue de Procore.

- Cliquez sur OK.

- Si c'est la première fois que vous vous connectez à cette source, vous serez invité à fournir votre jeton de porteur de partage Delta.

- Cliquez sur Connecter.

- Après l'authentification, sélectionnez les tableaux Procore Analytics que vous souhaitez importer dans votre rapport Power BI.

- Sélectionnez Charger pour afficher votre rapport ou sélectionnez Transformer les données pour effectuer plus de transformations dans Power Query.

Se connecter à un modèle existant

- Ouvrez Power BI Desktop.

- Cliquez sur la liste déroulante Transformer les données et sélectionnez Paramètres de la source de données .

- Sélectionnez Modifier les permissions.

- Cliquez sur Modifier.

- Saisissez le jeton que vous avez reçu d’Analytics 2.0.

- Cliquez sur Actualiser.

- Vos colonnes de budget personnalisées apparaîtront désormais dans les tableaux Budget et BudgetSnapshots.

Se connecter à SQL Server à l’aide de Python (SSIS)

Aperçu

L’outil Nuage Connect Access de Procore Analytics est une interface de ligne de commande (CLI) qui vous aide à configurer et à gérer les transferts de données de Procore vers MS SQL Server. Il se compose de deux composantes principales :

- user_exp.py (Utilitaire de configuration de la configuration)

- delta_share_to_azure_panda.py (Script de synchronisation des données)

Conditions préalables

- Python et pip installés sur votre système.

- Accès à Procore Delta Share.

- Informations d’identification du compte MS SQL Server.

- Installez les dépendances requises : pip install -r requirements.txt.

Étapes

- Configuration initiale

- Synchronisation des données

- Configuration du partage Delta

- MS SQL Server Configuration

- SSIS Configuration

Configuration initiale

- Exécutez l’utilitaire de configuration :

python user_exp.py

Cela vous aidera à configurer les éléments suivants :

- Configuration de la source Delta Share

- Configuration de la cible MS SQL Server

- Préférences de planification

Synchronisation des données

Après la configuration, vous avez deux options pour exécuter la synchronisation des données :

- Exécution directe python

delta_share_to_azure_panda.py

OU - Exécution planifiée

S’il est configuré lors de l’installation, le travail s’exécutera automatiquement selon votre planification cron.

Configuration du partage Delta

- Créez un nouveau fichier nommé config.share avec vos informations d’identification Delta Share au format JSON.

{

« shareCredentialsVersion » : 1,

« bearerToken » : « xxxxxxxxxxxxx »,

« endpoint » : « https://nvirginia.nuage. databricks.c... astores/xxxxxx"

}

- Obtenir les champs obligatoires :

Remarque : Ces détails peuvent être obtenus à partir de l’application Web Procore Analytics.- ShareCredentialsVersion : numéro de version (actuellement 1).

- BearerToken : votre jeton d’accès Delta Share.

- Point de terminaison : URL de votre point de terminaison Delta Share.

- Enregistrez le fichier dans un emplacement sûr.

- Lors de la configuration de la source de données, il vous sera demandé de fournir les informations suivantes :

- Liste des tableaux (séparés par des virgules).

- Laisser en blanc pour synchroniser tous les tableaux.

- Exemple : 'table1, t able2, table3'.

- Chemin d’accès à votre fichier « config.share » fichier.

MS SQL Server Configuration

Vous devez fournir les détails MS SQL Server suivants :

- Base de données

- Hébergeur

- mot de passe

- Schéma

- Nom d’utilisateur

SSIS Configuration

- À l’aide de la ligne de commande, accédez au dossier en saisissant « cd <chemin d’accès au dossier> <path to the folder> ».

- Installez les paquets requis à l’aide de 'pip install -r requirements.txt' ou 'python -m pip install -r requirements.txt'.

- Ouvrez SSIS et créez un nouveau projet.

- À partir de la boîte à outils SSIS, glisser-déposer l’activité « Exécuter la tâche de processus ».

- Double-cliquez sur « Exécuter la tâche de processus » et accédez à l’onglet Processus.

- Dans 'Exécutable', entrez le chemin d’accès à python.exe dans le dossier d’installation python.

- Dans 'WorkingDirectory', entrez un chemin d’accès au dossier contenant le script que vous souhaitez exécuter (sans nom de fichier de script).

- Dans 'Arguments', entrez le nom du script 'delta_share_to_azure_panda.py' que vous souhaitez exécuter avec le .py extension et sauvegarder.

- Cliquez sur le bouton « Démarrer » dans le volet supérieur :

- Lors de l’exécution de la tâche, la sortie de la console Python s’affiche dans la fenêtre de la console externe.

- Une fois la tâche terminée, elle affichera une coche verte :

Se connecter à SQL Server à l’aide de la bibliothèque Python

Aperçu

Ce guide fournit des instructions détaillées pour la configuration et l’utilisation du package d’intégration Delta Sharing sur un système d’exploitation Windows afin d’intégrer de manière transparente les données dans vos flux de travail avec Procore Analytics. Le package prend en charge plusieurs options d’exécution, ce qui vous permet de choisir la configuration et la méthode d’intégration souhaitées.

Conditions préalables

Assurez-vous d’avoir les éléments suivants avant de continuer :

- Référence SKU Analytique Procore 2.0

- Delta Sharing pofile fichier :

Obtenez votre fichier *.share contenant les informations d’identification Delta Sharing. Pour plus de commodité, copiez-le dans le répertoire du paquet. - Environnement Python : Installez Python 3 et pip sur votre système.

- Téléchargez Python.

- Vous pouvez également utiliser le Microsoft Store.

Étapes

- Préparer le colis

- Installer les dépendances

- Générer la configuration

- Configurer les tâches cron et l’exécution immédiate

- Exécution et maintenance

Préparer le colis

- Créez un nouveau fichier nommé config.share avec vos informations d’identification Delta Share au format JSON.

{

« shareCredentialsVersion » : 1,

« bearerToken » : « xxxxxxxxxxxxx »,

« endpoint » : « https://nvirginia.nuage. databricks.c... astores/xxxxxx"

}

- Obtenir les champs obligatoires.

Remarque : Ces détails peuvent être obtenus à partir de l’application Web Procore Analytics.- ShareCredentialsVersion : numéro de version (actuellement 1).

- BearerToken : votre jeton d’accès Delta Share.

- Point de terminaison : URL de votre point de terminaison Delta Share.

- Téléchargez et extrayez le package.

- Décompressez le paquet dans un répertoire de votre choix.

- Copiez le fichier de profil *.share Delta Sharing dans le répertoire du package pour y accéder facilement.

Installer les dépendances

- Ouvrez un terminal dans le répertoire des paquets.

- Exécutez la commande suivante pour installer les dépendances :

- pip install -r requirements.txt

Générer la configuration

- Générez le fichier config.yaml en exécutant python user_exp.py:

Ce script permet de générer le fichier config.yaml qui contient les informations d’identification et les paramètres nécessaires. - Lors de la configuration de la source de données, il vous sera demandé de fournir les informations suivantes :

- Liste des tableaux (séparés par des virgules).

- Laisser en blanc pour synchroniser tous les tableaux.

Exemple : 'table1, table2, table3'. - Chemin d’accès à votre fichier « config.share » fichier.

- Pour la première fois, vous fournirez vos informations d’identification telles que l’emplacement de configuration de la source Delta Share, les tables, la base de données, l’hôte, etc.

Remarque : Par la suite, vous pouvez réutiliser ou mettre à jour la configuration manuellement ou par l’user_exp.py python en cours d’exécution.

Configurer les tâches cron et l’exécution immédiate (facultatif)

- Décidez s’il faut configurer une tâche cron pour l’exécution automatique.

- Fournissez un échéancier cron :

- Format : * * * * * (minute, heure, jour du mois, mois, jour de la semaine).

- Exemple d’exécution quotidienne à 2 heures du matin : 0 2 * * *

- Pour vérifier les journaux de planification, le fichier 'procore_scheduling.log' sera créé dès que la planification est configurée.

Vous pouvez également vérifier la planification en exécutant la commande du terminal :

Pour Linux et MacOS :

Pour modifier/supprimer - modifiez le cron de l’échéancier en utilisant :

'''bash

EDITOR=nano crontab -e

```

- Après avoir exécuté la commande ci-dessus, vous devriez voir quelque chose de similaire à :

- 2 * * * * /users/your_user/snowflake/venv/bin/python /users/your_user/snowflake/sql_server_python/connection_config.py 2>&1 | while ligne lue ; do echo « $(date) - $line » ; done >> /Users/your_user/snowflake/sql_server_python/procore_scheduling.log # procore-data-import

- Vous pouvez également ajuster le cron de l’échéancier ou supprimer la ligne entière pour l’empêcher de fonctionner selon l’échéancier.

Pour Windows :

- Vérifiez que la tâche de l’échéancier est créée :

'''Powershell

schtasks /query /tn « ProcoreDeltaShareScheduling » /fo LIST /v

``` - Pour modifier/supprimer - tâche d’échéancier :

Ouvrez le planificateur de tâches :- Appuyez sur Win + R, tapez taskschd.msc, et appuyez sur Entrée.

- Accédez aux tâches planifiées.

- Dans le volet gauche, développez la bibliothèque du planificateur de tâches.

- Recherchez le dossier dans lequel votre tâche est enregistrée (par exemple, la bibliothèque du planificateur de tâches ou un dossier personnalisé).

- Trouvez votre tâche :

- Recherchez le nom de la tâche ProcoreDeltaShareScheduling.

- Cliquez dessus pour afficher ses détails dans le volet inférieur.

- Vérifiez son échéancier :

- Vérifiez l’onglet Déclencheurs pour voir quand la tâche est définie pour s’exécuter.

- Consultez l’onglet Historique pour confirmer les exécutions récentes.

- Pour supprimer la tâche :

- Supprimer la tâche de l’interface graphique.

Question relative à l’exécution immédiate :

- Possibilité d’exécuter un script pour copier les données immédiatement après la configuration.

- Après avoir généré le fichier config.yaml, l’interface de ligne de commande est prête à être exécutée à tout moment indépendamment, en exécutant un script pour copier les données, en fonction de votre package. Voir des exemples ci-dessous :

python delta_share_to_azure_panda.py

OU

python delta_share_to_sql_spark.py

OU

python delta_share_to_azure_dfs_spark.py

Exécution et maintenance

Problèmes courants et solutions

- Configuration de la tâche Cron :

- Assurez-vous que les permissions système sont correctement configurées.

- Vérifiez les journaux système si la tâche échoue à s’exécuter.

- Vérifiez que le script delta_share_to_azure_panda.py dispose des autorisations d’exécution.

- Fichier de configuration :

- Assurez-vous que le fichier config.yaml se trouve dans le même répertoire que le script.

- Sauvegardez le fichier avant d’apporter des modifications.

Soutien

Pour obtenir de l’aide supplémentaire :

- Consultez les journaux de script pour obtenir des messages d’erreur détaillés.

- Vérifiez que le fichier config.yaml ne contient pas d’erreurs de configuration.

- Contactez votre administrateur système pour les problèmes liés aux permissions.

- Contactez le support Procore pour les problèmes liés à l’accès à Delta Share.

- Examiner le journal pour les tables ayant échoué : failed_tables.log.

Remarques

- Sauvegardez toujours vos fichiers de configuration avant d’apporter des modifications.

- Testez de nouvelles configurations dans un environnement hors production pour éviter les interruptions.

Se connecter à SQL Server à l’aide de Python Spark

Aperçu

Ce guide fournit des instructions détaillées pour la configuration et l’utilisation du package d’intégration Delta Sharing sur un système d’exploitation Windows afin d’intégrer de manière transparente les données dans vos flux de travail avec Procore Analytics. Le package prend en charge plusieurs options d’exécution, ce qui vous permet de choisir la configuration et la méthode d’intégration souhaitées.

Conditions préalables

Assurez-vous d’avoir les éléments suivants avant de continuer :

- Référence SKU Analytique Procore 2.0

- Delta Sharing pofile fichier :

Obtenez votre fichier *.share contenant les informations d’identification Delta Sharing. Pour plus de commodité, copiez-le dans le répertoire du paquet. - Environnement Python : Installez Python 3 et pip sur votre système.

- Téléchargez Python.

- Vous pouvez également utiliser le Microsoft Store.

Étapes

- Préparer le colis

- Installer les dépendances

- Générer la configuration

- Configurer les tâches cron et l’exécution immédiate

- Exécution et maintenance

Préparer le colis

- Créez un nouveau fichier nommé config.share avec vos informations d’identification Delta Share au format JSON.

{

« shareCredentialsVersion » : 1,

« bearerToken » : « xxxxxxxxxxxxx »,

« endpoint » : « https://nvirginia.nuage. databricks.c... astores/xxxxxx"

}

- Obtenir les champs obligatoires.

Remarque : Ces détails peuvent être obtenus à partir de l’application Web Procore Analytics.- ShareCredentialsVersion : numéro de version (actuellement 1).

- BearerToken : votre jeton d’accès Delta Share.

- Point de terminaison : URL de votre point de terminaison Delta Share.

- Téléchargez et extrayez le package.

- Décompressez le paquet dans un répertoire de votre choix.

- Copiez le fichier de profil *.share Delta Sharing dans le répertoire du package pour y accéder facilement.

Installer les dépendances

- Ouvrez un terminal dans le répertoire des paquets.

- Exécutez la commande suivante pour installer les dépendances :

- pip install -r requirements.txt

Générer la configuration

- Générez le fichier config.yaml en exécutant python user_exp.py:

Ce script permet de générer le fichier config.yaml qui contient les informations d’identification et les paramètres nécessaires. - Lors de la configuration de la source de données, il vous sera demandé de fournir les informations suivantes :

- Liste des tableaux (séparés par des virgules).

- Laisser en blanc pour synchroniser tous les tableaux.

Exemple : 'table1, table2, table3'. - Chemin d’accès à votre fichier « config.share » fichier.

- Pour la première fois, vous fournirez vos informations d’identification telles que l’emplacement de configuration de la source Delta Share, les tables, la base de données, l’hôte, etc.

Remarque : Par la suite, vous pouvez réutiliser ou mettre à jour la configuration manuellement ou par l’user_exp.py python en cours d’exécution.

Configurer les tâches cron et l’exécution immédiate (facultatif)

- Décidez s’il faut configurer une tâche cron pour l’exécution automatique.

- Fournissez un échéancier cron :

- Format : * * * * * (minute, heure, jour du mois, mois, jour de la semaine).

- Exemple d’exécution quotidienne à 2 heures du matin : 0 2 * * *

- Pour vérifier les journaux de planification, le fichier 'procore_scheduling.log' sera créé dès que la planification est configurée.

Vous pouvez également vérifier la planification en exécutant la commande du terminal :

Pour Linux et MacOS :

Pour modifier/supprimer - modifiez le cron de l’échéancier en utilisant :

'''bash

EDITOR=nano crontab -e

```

- Après avoir exécuté la commande ci-dessus, vous devriez voir quelque chose de similaire à :

- 2 * * * * /users/your_user/snowflake/venv/bin/python /users/your_user/snowflake/sql_server_python/connection_config.py 2>&1 | while ligne lue ; do echo « $(date) - $line » ; done >> /Users/your_user/snowflake/sql_server_python/procore_scheduling.log # procore-data-import

- Vous pouvez également ajuster le cron de l’échéancier ou supprimer la ligne entière pour l’empêcher de fonctionner selon l’échéancier.

Pour Windows :

- Vérifiez que la tâche de l’échéancier est créée :

'''Powershell

schtasks /query /tn « ProcoreDeltaShareScheduling » /fo LIST /v

``` - Pour modifier/supprimer - tâche d’échéancier :

Ouvrez le planificateur de tâches :- Appuyez sur Win + R, tapez taskschd.msc, et appuyez sur Entrée.

- Accédez aux tâches planifiées.

- Dans le volet gauche, développez la bibliothèque du planificateur de tâches.

- Recherchez le dossier dans lequel votre tâche est enregistrée (par exemple, la bibliothèque du planificateur de tâches ou un dossier personnalisé).

- Trouvez votre tâche :

- Recherchez le nom de la tâche ProcoreDeltaShareScheduling.

- Cliquez dessus pour afficher ses détails dans le volet inférieur.

- Vérifiez son échéancier :

- Vérifiez l’onglet Déclencheurs pour voir quand la tâche est définie pour s’exécuter.

- Consultez l’onglet Historique pour confirmer les exécutions récentes.

- Pour supprimer la tâche :

- Supprimer la tâche de l’interface graphique.

Question relative à l’exécution immédiate :

- Possibilité d’exécuter un script pour copier les données immédiatement après la configuration.

- Après avoir généré le fichier config.yaml, l’interface de ligne de commande est prête à être exécutée à tout moment indépendamment, en exécutant un script pour copier les données, en fonction de votre package. Voir des exemples ci-dessous :

python delta_share_to_azure_panda.py

OU

python delta_share_to_sql_spark.py

OU

python delta_share_to_azure_dfs_spark.py

Exécution et maintenance

Problèmes courants et solutions

- Configuration de la tâche Cron :

- Assurez-vous que les permissions système sont correctement configurées.

- Vérifiez les journaux système si la tâche échoue à s’exécuter.

- Vérifiez que le script delta_share_to_azure_panda.py dispose des autorisations d’exécution.

- Fichier de configuration :

- Assurez-vous que le fichier config.yaml se trouve dans le même répertoire que le script.

- Sauvegardez le fichier avant d’apporter des modifications.

Soutien

Pour obtenir de l’aide supplémentaire :

- Consultez les journaux de script pour obtenir des messages d’erreur détaillés.

- Vérifiez que le fichier config.yaml ne contient pas d’erreurs de configuration.

- Contactez votre administrateur système pour les problèmes liés aux permissions.

- Contactez le support Procore pour les problèmes liés à l’accès à Delta Share.

- Examiner le journal pour les tables ayant échoué : failed_tables.log.

Remarques

- Sauvegardez toujours vos fichiers de configuration avant d’apporter des modifications.

- Testez de nouvelles configurations dans un environnement hors production pour éviter les interruptions.

Se connecter à ADLS à l’aide d’Azure Functions

Aperçu

Ce guide vous guide tout au long de la configuration et du déploiement d’une fonction Azure pour l’intégration de données Delta Sharing à Procore Analytics. La fonction Azure permet un traitement efficace des données et des flux de travail de partage avec les profils Delta Sharing.

Conditions préalables

- Référence SKU de Procore Analytics 2.0.

- Fichier de profil Delta Sharing :

- Votre fichier *.share contenant les informations d’identification Delta Sharing. Pour plus de commodité, placez-le à l’intérieur de l’emballage téléchargé.

- Environnement Python :

- Installez Python 3.9+ et pip sur votre système.

- Configuration d’Azure :

- Azure CLI installé et connecté.

- Les outils essentiels Azure Functions sont installés.

Étapes

- Prepare the Package

- Install Dependencies

- Generate Configuration

- Azure CLI Setup

- Install Azure Functions Core Tools

- Prepare the Azure Function

- Deployment

- Validation

Préparer le colis

- Téléchargez le package requis (adls_azure_function ou sql_server_azure_function).

- Extrayez les fichiers du package dans un répertoire local.

- Placer le fichier de partage Delta :

- Copiez votre fichier de profil *.share Delta Sharing dans le répertoire extrait.

Installer les dépendances

- Ouvrez un terminal dans le répertoire des paquets.

- Exécutez la commande suivante pour installer les dépendances Python requises :

- pip install -r requirements.txt

Générer la configuration

- Générez le fichier config.yaml en exécutant :

- user_exp.py python

- Le script vous invite à entrer des informations d’identification telles que :

- Tableaux

- Nom de la base de données

- Hébergeur

- Informations d’identification supplémentaires.

- La configuration peut être réutilisée ou mise à jour manuellement ou en réexécutant python user_exp.py.

Configuration de l’interface de ligne de commande Azure

- Connectez-vous à Azure.

- Exécutez la commande suivante pour vous connecter :

az login - Vérifier le compte Azure :

- az compte afficher

- Si la commande az n’est pas disponible, installez l’interface de ligne de commande Azure en suivant les instructions trouvées ici : Microsoft Learn.

Installer les outils essentiels d’Azure Functions

Aller à

to pour obtenir des instructions sur l’installation des outils essentiels Azure Functions.Préparer la fonction AzurePrepare the Azure Function

- Utilisezpour créer les éléments suivants :

- Une application fonctionnelle

- Un groupe de ressources

- Plan de consommation

- Compte de stockage

- Définissez une planification Cron personnalisée (facultatif).

- Ouvrez function_app.py dans un éditeur.

- Localisez la ligne : @app.timer_trigger(schedule="0 0 */8 * * *",

- Remplacez la planification par votre expression Cron personnalisée et enregistrez le fichier.

Déploiement

- Ouvrez un terminal dans le répertoire du paquet (adls_azure_function).

- Exécutez la commande de déploiement suivante :

- func azure functionapp publish <FunctionAppName> --build remote --python --clean

- Remplacez <FunctionAppName> par le nom de votre application de fonction Azure dans votre abonnement Azure.

Validation

- Assurez-vous que le déploiement réussit en vérifiant l’état de votre application de fonction dans le portail Azure.

- Surveillez les journaux pour vérifier que la fonction s’exécute comme prévu.

Se connecter à ADLS à l’aide de Python

Aperçu

Ce guide fournit des instructions détaillées pour la configuration et l’utilisation du package d’intégration Delta Sharing sur un système d’exploitation Windows afin d’intégrer de manière transparente les données dans vos flux de travail avec Procore Analytics. Le package prend en charge plusieurs options d’exécution, ce qui vous permet de choisir la configuration et la méthode d’intégration souhaitées.

Conditions préalables

Assurez-vous d’avoir les éléments suivants avant de continuer :

- Référence SKU Analytique Procore 2.0

- Delta Sharing pofile fichier :

Obtenez votre fichier *.share contenant les informations d’identification Delta Sharing. Pour plus de commodité, copiez-le dans le répertoire du paquet. - Environnement Python : Installez Python 3 et pip sur votre système.

- Téléchargez Python.

- Vous pouvez également utiliser le Microsoft Store.

Étapes

- Préparer le colis

- Installer les dépendances

- Générer la configuration

- Configurer les tâches cron et l’exécution immédiate

- Exécution et maintenance

Préparer le colis

- Créez un nouveau fichier nommé config.share avec vos informations d’identification Delta Share au format JSON.

{

« shareCredentialsVersion » : 1,

« bearerToken » : « xxxxxxxxxxxxx »,

« endpoint » : « https://nvirginia.nuage. databricks.c... astores/xxxxxx"

}

- Obtenir les champs obligatoires.

Remarque : Ces détails peuvent être obtenus à partir de l’application Web Procore Analytics.- ShareCredentialsVersion : numéro de version (actuellement 1).

- BearerToken : votre jeton d’accès Delta Share.

- Point de terminaison : URL de votre point de terminaison Delta Share.

- Téléchargez et extrayez le package.

- Décompressez le paquet dans un répertoire de votre choix.

- Copiez le fichier de profil *.share Delta Sharing dans le répertoire du package pour y accéder facilement.

Installer les dépendances

- Ouvrez un terminal dans le répertoire des paquets.

- Exécutez la commande suivante pour installer les dépendances :

- pip install -r requirements.txt

Générer la configuration

- Générez le fichier config.yaml en exécutant python user_exp.py:

Ce script permet de générer le fichier config.yaml qui contient les informations d’identification et les paramètres nécessaires. - Lors de la configuration de la source de données, il vous sera demandé de fournir les informations suivantes :

- Liste des tableaux (séparés par des virgules).

- Laisser en blanc pour synchroniser tous les tableaux.

Exemple : 'table1, table2, table3'. - Chemin d’accès à votre fichier « config.share » fichier.

- Pour la première fois, vous fournirez vos informations d’identification telles que l’emplacement de configuration de la source Delta Share, les tables, la base de données, l’hôte, etc.

Remarque : Par la suite, vous pouvez réutiliser ou mettre à jour la configuration manuellement ou par l’user_exp.py python en cours d’exécution.

Configurer les tâches cron et l’exécution immédiate (facultatif)

- Décidez s’il faut configurer une tâche cron pour l’exécution automatique.

- Fournissez un échéancier cron :

- Format : * * * * * (minute, heure, jour du mois, mois, jour de la semaine).

- Exemple d’exécution quotidienne à 2 heures du matin : 0 2 * * *

- Pour vérifier les journaux de planification, le fichier 'procore_scheduling.log' sera créé dès que la planification est configurée.

Vous pouvez également vérifier la planification en exécutant la commande du terminal :

Pour Linux et MacOS :

Pour modifier/supprimer - modifiez le cron de l’échéancier en utilisant :

'''bash

EDITOR=nano crontab -e

```

- Après avoir exécuté la commande ci-dessus, vous devriez voir quelque chose de similaire à :

- 2 * * * * /users/your_user/snowflake/venv/bin/python /users/your_user/snowflake/sql_server_python/connection_config.py 2>&1 | while ligne lue ; do echo « $(date) - $line » ; done >> /Users/your_user/snowflake/sql_server_python/procore_scheduling.log # procore-data-import

- Vous pouvez également ajuster le cron de l’échéancier ou supprimer la ligne entière pour l’empêcher de fonctionner selon l’échéancier.

Pour Windows :

- Vérifiez que la tâche de l’échéancier est créée :

'''Powershell

schtasks /query /tn « ProcoreDeltaShareScheduling » /fo LIST /v

``` - Pour modifier/supprimer - tâche d’échéancier :

Ouvrez le planificateur de tâches :- Appuyez sur Win + R, tapez taskschd.msc, et appuyez sur Entrée.

- Accédez aux tâches planifiées.

- Dans le volet gauche, développez la bibliothèque du planificateur de tâches.

- Recherchez le dossier dans lequel votre tâche est enregistrée (par exemple, la bibliothèque du planificateur de tâches ou un dossier personnalisé).

- Trouvez votre tâche :

- Recherchez le nom de la tâche ProcoreDeltaShareScheduling.

- Cliquez dessus pour afficher ses détails dans le volet inférieur.

- Vérifiez son échéancier :

- Vérifiez l’onglet Déclencheurs pour voir quand la tâche est définie pour s’exécuter.

- Consultez l’onglet Historique pour confirmer les exécutions récentes.

- Pour supprimer la tâche :

- Supprimer la tâche de l’interface graphique.

Question relative à l’exécution immédiate :

- Possibilité d’exécuter un script pour copier les données immédiatement après la configuration.

- Après avoir généré le fichier config.yaml, l’interface de ligne de commande est prête à être exécutée à tout moment indépendamment, en exécutant un script pour copier les données, en fonction de votre package. Voir des exemples ci-dessous :

python delta_share_to_azure_panda.py

OU

python delta_share_to_sql_spark.py

OU

python delta_share_to_azure_dfs_spark.py

Exécution et maintenance

Problèmes courants et solutions

- Configuration de la tâche Cron :

- Assurez-vous que les permissions système sont correctement configurées.

- Vérifiez les journaux système si la tâche échoue à s’exécuter.

- Vérifiez que le script delta_share_to_azure_panda.py dispose des autorisations d’exécution.

- Fichier de configuration :

- Assurez-vous que le fichier config.yaml se trouve dans le même répertoire que le script.

- Sauvegardez le fichier avant d’apporter des modifications.

Soutien

Pour obtenir de l’aide supplémentaire :

- Consultez les journaux de script pour obtenir des messages d’erreur détaillés.

- Vérifiez que le fichier config.yaml ne contient pas d’erreurs de configuration.

- Contactez votre administrateur système pour les problèmes liés aux permissions.

- Contactez le support Procore pour les problèmes liés à l’accès à Delta Share.

- Examiner le journal pour les tables ayant échoué : failed_tables.log.

Remarques

- Sauvegardez toujours vos fichiers de configuration avant d’apporter des modifications.

- Testez de nouvelles configurations dans un environnement hors production pour éviter les interruptions.

Se connecter à ADLS à l’aide de Spark

Aperçu

Ce guide fournit des instructions détaillées pour la configuration et l’utilisation du package d’intégration Delta Sharing sur un système d’exploitation Windows afin d’intégrer de manière transparente les données dans vos flux de travail avec Procore Analytics. Le package prend en charge plusieurs options d’exécution, ce qui vous permet de choisir la configuration et la méthode d’intégration souhaitées.

Conditions préalables

Assurez-vous d’avoir les éléments suivants avant de continuer :

- Référence SKU Analytique Procore 2.0

- Delta Sharing pofile fichier :

Obtenez votre fichier *.share contenant les informations d’identification Delta Sharing. Pour plus de commodité, copiez-le dans le répertoire du paquet. - Environnement Python : Installez Python 3 et pip sur votre système.

- Téléchargez Python.

- Vous pouvez également utiliser le Microsoft Store.

Étapes

- Préparer le colis

- Installer les dépendances

- Générer la configuration

- Configurer les tâches cron et l’exécution immédiate

- Exécution et maintenance

Préparer le colis

- Créez un nouveau fichier nommé config.share avec vos informations d’identification Delta Share au format JSON.

{

« shareCredentialsVersion » : 1,

« bearerToken » : « xxxxxxxxxxxxx »,

« endpoint » : « https://nvirginia.nuage. databricks.c... astores/xxxxxx"

}

- Obtenir les champs obligatoires.

Remarque : Ces détails peuvent être obtenus à partir de l’application Web Procore Analytics.- ShareCredentialsVersion : numéro de version (actuellement 1).

- BearerToken : votre jeton d’accès Delta Share.

- Point de terminaison : URL de votre point de terminaison Delta Share.

- Téléchargez et extrayez le package.

- Décompressez le paquet dans un répertoire de votre choix.

- Copiez le fichier de profil *.share Delta Sharing dans le répertoire du package pour y accéder facilement.

Installer les dépendances

- Ouvrez un terminal dans le répertoire des paquets.

- Exécutez la commande suivante pour installer les dépendances :

- pip install -r requirements.txt

Générer la configuration

- Générez le fichier config.yaml en exécutant python user_exp.py:

Ce script permet de générer le fichier config.yaml qui contient les informations d’identification et les paramètres nécessaires. - Lors de la configuration de la source de données, il vous sera demandé de fournir les informations suivantes :

- Liste des tableaux (séparés par des virgules).

- Laisser en blanc pour synchroniser tous les tableaux.

Exemple : 'table1, table2, table3'. - Chemin d’accès à votre fichier « config.share » fichier.

- Pour la première fois, vous fournirez vos informations d’identification telles que l’emplacement de configuration de la source Delta Share, les tables, la base de données, l’hôte, etc.

Remarque : Par la suite, vous pouvez réutiliser ou mettre à jour la configuration manuellement ou par l’user_exp.py python en cours d’exécution.

Configurer les tâches cron et l’exécution immédiate (facultatif)

- Décidez s’il faut configurer une tâche cron pour l’exécution automatique.

- Fournissez un échéancier cron :

- Format : * * * * * (minute, heure, jour du mois, mois, jour de la semaine).

- Exemple d’exécution quotidienne à 2 heures du matin : 0 2 * * *

- Pour vérifier les journaux de planification, le fichier 'procore_scheduling.log' sera créé dès que la planification est configurée.

Vous pouvez également vérifier la planification en exécutant la commande du terminal :

Pour Linux et MacOS :

Pour modifier/supprimer - modifiez le cron de l’échéancier en utilisant :

'''bash

EDITOR=nano crontab -e

```

- Après avoir exécuté la commande ci-dessus, vous devriez voir quelque chose de similaire à :

- 2 * * * * /users/your_user/snowflake/venv/bin/python /users/your_user/snowflake/sql_server_python/connection_config.py 2>&1 | while ligne lue ; do echo « $(date) - $line » ; done >> /Users/your_user/snowflake/sql_server_python/procore_scheduling.log # procore-data-import

- Vous pouvez également ajuster le cron de l’échéancier ou supprimer la ligne entière pour l’empêcher de fonctionner selon l’échéancier.

Pour Windows :

- Vérifiez que la tâche de l’échéancier est créée :

'''Powershell

schtasks /query /tn « ProcoreDeltaShareScheduling » /fo LIST /v

``` - Pour modifier/supprimer - tâche d’échéancier :

Ouvrez le planificateur de tâches :- Appuyez sur Win + R, tapez taskschd.msc, et appuyez sur Entrée.

- Accédez aux tâches planifiées.

- Dans le volet gauche, développez la bibliothèque du planificateur de tâches.

- Recherchez le dossier dans lequel votre tâche est enregistrée (par exemple, la bibliothèque du planificateur de tâches ou un dossier personnalisé).

- Trouvez votre tâche :

- Recherchez le nom de la tâche ProcoreDeltaShareScheduling.

- Cliquez dessus pour afficher ses détails dans le volet inférieur.

- Vérifiez son échéancier :

- Vérifiez l’onglet Déclencheurs pour voir quand la tâche est définie pour s’exécuter.

- Consultez l’onglet Historique pour confirmer les exécutions récentes.

- Pour supprimer la tâche :

- Supprimer la tâche de l’interface graphique.

Question relative à l’exécution immédiate :

- Possibilité d’exécuter un script pour copier les données immédiatement après la configuration.

- Après avoir généré le fichier config.yaml, l’interface de ligne de commande est prête à être exécutée à tout moment indépendamment, en exécutant un script pour copier les données, en fonction de votre package. Voir des exemples ci-dessous :

python delta_share_to_azure_panda.py

OU

python delta_share_to_sql_spark.py

OU

python delta_share_to_azure_dfs_spark.py

Exécution et maintenance

Problèmes courants et solutions

- Configuration de la tâche Cron :

- Assurez-vous que les permissions système sont correctement configurées.

- Vérifiez les journaux système si la tâche échoue à s’exécuter.

- Vérifiez que le script delta_share_to_azure_panda.py dispose des autorisations d’exécution.

- Fichier de configuration :

- Assurez-vous que le fichier config.yaml se trouve dans le même répertoire que le script.

- Sauvegardez le fichier avant d’apporter des modifications.

Soutien

Pour obtenir de l’aide supplémentaire :

- Consultez les journaux de script pour obtenir des messages d’erreur détaillés.

- Vérifiez que le fichier config.yaml ne contient pas d’erreurs de configuration.

- Contactez votre administrateur système pour les problèmes liés aux permissions.

- Contactez le support Procore pour les problèmes liés à l’accès à Delta Share.

- Examiner le journal pour les tables ayant échoué : failed_tables.log.

Remarques

- Sauvegardez toujours vos fichiers de configuration avant d’apporter des modifications.

- Testez de nouvelles configurations dans un environnement hors production pour éviter les interruptions.

Se connecter à Fabric Lakehouse à l’aide de Data Factory

Aperçu

L’intégration de Delta Sharing à Microsoft Fabric Data Factory permet un accès et un traitement transparents aux tables Delta partagées pour vos flux de travail d’analyse avec Procore Analytics 2.0. Delta Sharing, un protocole ouvert pour une collaboration sécurisée des données, garantit que les organisations peuvent partager des données sans doublon.

Conditions préalables

- Référence SKU Analytique Procore 2.0

- Informations d’identification de partage Delta:

- Obtenez le fichier d’informations d’identification Delta Sharing share.json (ou équivalent) auprès de votre fournisseur de données.

- Ce fichier doit comprendre :

- URL du point de terminaison : URL du serveur de partage Delta.

- Jeton au porteur : Utilisé pour un accès sécurisé aux données.

- Configuration de Microsoft Fabric :

- Un compte de locataire Microsoft Fabric avec un abonnement actif.

- Accès à un espace de travail compatible avec Microsoft Fabric.

Étapes

- Passer à l’expérience Data Factory

- Configurer le flux de données

- Effectuer des transformations de données

- Validation et suivi

Passer à l’expérience Data Factory

- Accédez à votre espace de travail Microsoft Fabric.

- Sélectionnez Nouveau, puis Dataflow Gen2.

Configurer le flux de données

- Accédez à l’éditeur de flux de données.

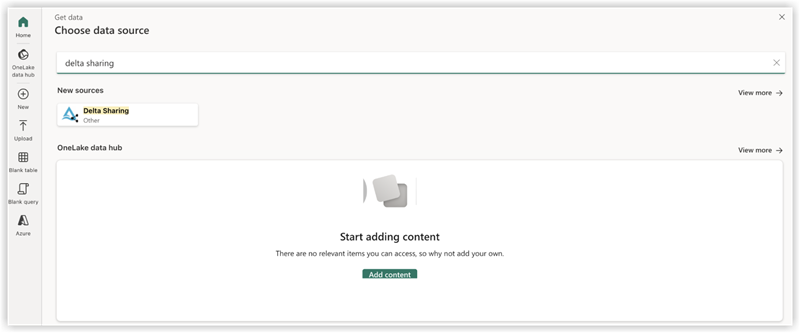

- Cliquez sur Obtenir des données et sélectionnez Plus.

- Sous Nouvelle source, sélectionnez Delta Sharing Other (Delta Sharing Other) comme source de données.

- Saisissez les informations suivantes :

- URL: à partir de votre fichier de configuration Delta Sharing.

- Jeton du porteur: Trouvé dans votre fichier config.share.

- Cliquez sur Suivant et sélectionnez les tables souhaitées.

- Cliquez sur Créer pour terminer la configuration.

Effectuer des transformations de données

Après avoir configuré le flux de données, vous pouvez maintenant appliquer des transformations aux données Delta partagées. Choisissez votre option Delta Sharing Data dans la liste ci-dessous :

- Ajouter une destination de données

- Créer/ouvrir Lakehouse

Ajouter une destination de données

- Accédez à Data Factory.

- Cliquez sur Ajouter une destination de données.

- Sélectionnez Lakehouse comme cible et cliquez sur Suivant.

- Choisissez votre cible de destination et confirmez en cliquant sur Suivant.

Créer-Ouvrir Lakehouse

- Créez/ouvrez votreLakehouse et cliquez sur Obtenir des données.

- Sélectionnez Nouveau flux de données de 2e génération.

- Cliquez sur Obtenir des données, puis sur Plus et recherchez Partage Delta.

- Entrez le jeton du support d’URL à partir de votre fichier config.share, puis sélectionnez Next.

- Choisissez vos données/table(s) à télécharger et cliquez sur Suivant.

- Après ces manipulations, vous devriez avoir toutes les données sélectionnées dans votre Fabric Lakehouse.

Validation et suivi

Testez vos pipelines et flux de données pour garantir une exécution fluide. Utiliser des outils de surveillance au sein des données

Usine pour suivre les progrès et les journaux pour chaque activité.

Se connecter à Fabric Lakehouse à l’aide de Fabric Notebooks

Aperçu

L’utilisation de Data Factory dans Microsoft Fabric avec le partage Delta permet une intégration et un traitement transparents des tables Delta partagées dans le cadre de vos flux de travail d’analyse avec Procore Analytics 2.0. Delta Sharing est un protocole ouvert pour le partage sécurisé des données, permettant la collaboration entre les organisations sans dupliquer les données.

Ce guide vous guide tout au long des étapes de configuration et d’utilisation de Data Factory dans Fabric avec Delta Sharing, à l’aide de blocs-notes pour le traitement et l’exportation de données vers un Lakehouse.

Conditions préalables

- Référence SKU Analytique Procore 2.0

- Informations d’identification de partage Delta :

- Accès aux informations d’identification Delta Sharing fournies par un fournisseur de données.

- Un fichier de profil de partage (config.share) contenant :

- URL du point de terminaison (URL du serveur de partage Delta).

- Jeton d’accès (jeton du porteur pour un accès sécurisé aux données).

- Créez votre fichier config.yaml avec des informations d’identification spécifiques.

- Environnement Microsoft Fabric :

- Un compte de locataire Microsoft Fabric avec un abonnement actif.

- Un espace de travail compatible avec Fabric.

- Paquets et scripts :

- Téléchargez le paquet fabric-lakehouse. Le répertoire doit comprendre :

- ds_to_lakehouse.py : Code du bloc-notes.

- readme.md : Directives.

- Téléchargez le paquet fabric-lakehouse. Le répertoire doit comprendre :

Étapes

Configurer la configuration

- Créez le fichier config.yaml et définissez la configuration dans la structure suivante

source_config :

config_path : chemin/vers/votre/delta-sharing-credentials-file.share

tables : # Facultatif - Laisser vide pour traiter toutes les tables

- table_name1

- table_name2

target_config :

lakehouse_path : chemin/vers/votre/tissu/maison-du-lac/tables/ # chemin d’accès à la maison du lac de tissu

Configurez votre maison au bord du lac

- Ouvrez votre espace de travail Microsoft Fabric.

- Accédez à votre Lakehouse et cliquez sur Ouvrir le bloc-notes, puis sur Nouveau bloc-notes.

- Si vous ne connaissez pas la valeur dans config.yaml#lakehouse_path, Vous pouvez le copier à partir de l’écran.

- Cliquez sur les points de suspension sur Fichiers et sélectionnez Copier le chemin ABFS:

3. Copiez le code de ds_to_lakehouse.py et collez-le dans la fenêtre du bloc-notes (Pyspark Python) :

L’étape suivante consiste à télécharger vos propres fichiers config.yaml et config.share dans le dossier Resources de Lakehouse. Vous pouvez créer votre propre répertoire ou utiliser un répertoire intégré (déjà créé pour les ressources par Lakehouse) :

L’exemple ci-dessous montre un répertoire intégré standard pour un fichier config.yaml .

Remarque : Assurez-vous de téléverser les deux fichiers au même niveau et pour la propriété config_path:

4. Vérifiez le code du bloc-notes, lignes 170-175.

L’exemple ci-dessous montre les modifications de ligne nécessaires :

config_path = « ./env/config.yaml »

à

config_path = « ./builtin/config.yaml»

Étant donné que les fichiers se trouvent dans un dossier intégré et non dans un environnement personnalisé, assurez-vous de surveiller votre propre structure des fichiers. Vous pouvez les charger dans différents dossiers, mais dans ce cas, mettez à jour le code du bloc-notes pour trouver correctement le fichier config.yaml .

5. Cliquez sur Exécuter la cellule :

Validation

- Une fois le travail terminé, vérifiez que les données ont bien été copiées dans votre Lakehouse.

- Vérifiez les tables spécifiées et assurez-vous que les données correspondent aux tables Delta partagées.

- Attendez que le travail soit terminé, il devrait copier toutes les données.

Se connecter à SQL Server à l’aide d’Azure Functions

Aperçu

Ce guide vous guide tout au long de la configuration et du déploiement d’une fonction Azure pour l’intégration de données Delta Sharing à Procore Analytics. La fonction Azure permet un traitement efficace des données et des flux de travail de partage avec les profils Delta Sharing.

Conditions préalables

- Référence SKU de Procore Analytics 2.0.

- Fichier de profil Delta Sharing :

- Votre fichier *.share contenant les informations d’identification Delta Sharing. Pour plus de commodité, placez-le à l’intérieur de l’emballage téléchargé.

- Environnement Python :

- Installez Python 3.9+ et pip sur votre système.

- Configuration d’Azure :

- Azure CLI installé et connecté.

- Les outils essentiels Azure Functions sont installés.

Étapes

- Prepare the Package

- Install Dependencies

- Generate Configuration

- Azure CLI Setup

- Install Azure Functions Core Tools

- Prepare the Azure Function

- Deployment

- Validation

Préparer le colis

- Téléchargez le package requis (adls_azure_function ou sql_server_azure_function).

- Extrayez les fichiers du package dans un répertoire local.

- Placer le fichier de partage Delta :

- Copiez votre fichier de profil *.share Delta Sharing dans le répertoire extrait.

Installer les dépendances

- Ouvrez un terminal dans le répertoire des paquets.

- Exécutez la commande suivante pour installer les dépendances Python requises :

- pip install -r requirements.txt

Générer la configuration

- Générez le fichier config.yaml en exécutant :

- user_exp.py python

- Le script vous invite à entrer des informations d’identification telles que :

- Tableaux

- Nom de la base de données

- Hébergeur

- Informations d’identification supplémentaires.

- La configuration peut être réutilisée ou mise à jour manuellement ou en réexécutant python user_exp.py.

Configuration de l’interface de ligne de commande Azure

- Connectez-vous à Azure.

- Exécutez la commande suivante pour vous connecter :

az login - Vérifier le compte Azure :

- az compte afficher

- Si la commande az n’est pas disponible, installez l’interface de ligne de commande Azure en suivant les instructions trouvées ici : Microsoft Learn.

Installer les outils essentiels d’Azure Functions

Aller à

to pour obtenir des instructions sur l’installation des outils essentiels Azure Functions.Préparer la fonction AzurePrepare the Azure Function

- Utilisezpour créer les éléments suivants :

- Une application fonctionnelle

- Un groupe de ressources

- Plan de consommation

- Compte de stockage

- Définissez une planification Cron personnalisée (facultatif).

- Ouvrez function_app.py dans un éditeur.

- Localisez la ligne : @app.timer_trigger(schedule="0 0 */8 * * *",

- Remplacez la planification par votre expression Cron personnalisée et enregistrez le fichier.

Déploiement

- Ouvrez un terminal dans le répertoire du paquet (adls_azure_function).

- Exécutez la commande de déploiement suivante :

- func azure functionapp publish <FunctionAppName> --build remote --python --clean

- Remplacez <FunctionAppName> par le nom de votre application de fonction Azure dans votre abonnement Azure.

Validation

- Assurez-vous que le déploiement réussit en vérifiant l’état de votre application de fonction dans le portail Azure.

- Surveillez les journaux pour vérifier que la fonction s’exécute comme prévu.

Se connecter à SQL Server à l’aide de Data Factory

Vue d’ensemble

Ce document fournit des instructions pas à pas pour la configuration d’un pipeline de données dans Microsoft Fabric afin de transférer des données de Delta Share vers un entrepôt SQL. Cette configuration permet une intégration transparente des données entre les sources Delta Lake et les destinations SQL.

Conditions préalables

- Compte Microsoft Fabric actif avec les autorisations appropriées.

- Informations d’identification Delta Share.

- Informations d’identification de l’entrepôt SQL.

- Accès au flux de données Gen2 dans Fabric.

Étapes

- Flux de données d’accès Gen2

- Configurer les données Target

- Configurer la connexion Delta Share

- Configurer la destination des données

- Finaliser et déployer

- Vérification

- Dépannage

Flux de données d’accès Gen2

- Connectez-vous à votre compte Microsoft Fabric.

- Accédez à l’espace de travail.

- Sélectionnez « Flux de données Gen2 » parmi les options disponibles.

Configurer la source de données

- Cliquez sur « Données provenant d’une autre source » pour commencer la configuration.

- À partir de l’écran Obtenir des données, procédez comme suit :

- Localisez la barre de recherche intitulée « Choisir une source de données ».

- Tapez « partage delta » dans le champ de recherche.

- Sélectionnez Partage delta dans les résultats.

Configurer la connexion Delta Share

- Saisissez vos informations d’identification Delta Share lorsque vous y êtes invité.

- Assurez-vous que tous les champs obligatoires sont remplis avec exactitude.

- Validez la connexion si possible.

- Cliquez sur « Suivant » pour continuer.

- Consultez la liste des tableaux disponibles :

- Toutes les tables auxquelles vous avez accès seront affichées.

- Sélectionnez les tables souhaitées pour le transfert.

Configurer la destination des données

- Cliquez sur « Ajouter une destination de données ».

- Sélectionnez « Entrepôt SQL » comme destination.

- Entrez les informations d’identification SQL :

- Détails du serveur.

- Informations d’authentification.

- Spécifications de la base de données.

- Vérifiez les paramètres de connexion.

Finaliser et déployer

- Passez en revue toutes les configurations.

- Cliquez sur « Publier » pour déployer le flux de données.

- Attendez le message de confirmation.

Vérification

- Accédez à votre entrepôt SQL.

- Vérifiez que les données sont disponibles et correctement structurées.

- Exécutez des requêtes de test pour garantir l’intégrité des données.

Dépannage

Problèmes courants et solutions :

- Échecs de connexion : vérifiez les informations d’identification et la connectivité réseau.

- Tables manquantes : Cochez les autorisations Delta Share.

- Problèmes de performances : examinez les paramètres d’allocation et d’optimisation des ressources.

Se connecter à SQL Server à l’aide de Fabric Notebook

Aperçu

L’utilisation de Data Factory dans Microsoft Fabric avec le partage Delta permet une intégration et un traitement transparents des tables Delta partagées dans le cadre de vos flux de travail d’analyse avec Procore Analytics 2.0. Delta Sharing est un protocole ouvert pour le partage sécurisé des données, permettant la collaboration entre les organisations sans dupliquer les données.

Ce guide vous guide tout au long des étapes de configuration et d’utilisation de Data Factory dans Fabric avec Delta Sharing, à l’aide de blocs-notes pour le traitement et l’exportation de données vers un Lakehouse.

Conditions préalables

- Référence SKU Analytique Procore 2.0

- Informations d’identification de partage Delta :

- Accès aux informations d’identification Delta Sharing fournies par un fournisseur de données.

- Un fichier de profil de partage (config.share) contenant :

- URL du point de terminaison (URL du serveur de partage Delta).

- Jeton d’accès (jeton du porteur pour un accès sécurisé aux données).

- Créez votre fichier config.yaml avec des informations d’identification spécifiques.

- Environnement Microsoft Fabric :

- Un compte de locataire Microsoft Fabric avec un abonnement actif.

- Un espace de travail compatible avec Fabric.

- Paquets et scripts :

- Téléchargez le paquet fabric-lakehouse. Le répertoire doit comprendre :

- ds_to_lakehouse.py : Code du bloc-notes.

- readme.md : Directives.

- Téléchargez le paquet fabric-lakehouse. Le répertoire doit comprendre :

Étapes

Configurer la configuration

- Créez le fichier config.yaml et définissez la configuration dans la structure suivante

source_config :

config_path : chemin/vers/votre/delta-sharing-credentials-file.share

tables : # Facultatif - Laisser vide pour traiter toutes les tables

- table_name1

- table_name2

target_config :

lakehouse_path : chemin/vers/votre/tissu/maison-du-lac/tables/ # chemin d’accès à la maison du lac de tissu

Configurez votre maison au bord du lac

- Ouvrez votre espace de travail Microsoft Fabric.

- Accédez à votre Lakehouse et cliquez sur Ouvrir le bloc-notes, puis sur Nouveau bloc-notes.

- Si vous ne connaissez pas la valeur dans config.yaml#lakehouse_path, Vous pouvez le copier à partir de l’écran.

- Cliquez sur les points de suspension sur Fichiers et sélectionnez Copier le chemin ABFS:

3. Copiez le code de ds_to_lakehouse.py et collez-le dans la fenêtre du bloc-notes (Pyspark Python) :

L’étape suivante consiste à télécharger vos propres fichiers config.yaml et config.share dans le dossier Resources de Lakehouse. Vous pouvez créer votre propre répertoire ou utiliser un répertoire intégré (déjà créé pour les ressources par Lakehouse) :

L’exemple ci-dessous montre un répertoire intégré standard pour un fichier config.yaml .

Remarque : Assurez-vous de téléverser les deux fichiers au même niveau et pour la propriété config_path:

4. Vérifiez le code du bloc-notes, lignes 170-175.

L’exemple ci-dessous montre les modifications de ligne nécessaires :

config_path = « ./env/config.yaml »

à

config_path = « ./builtin/config.yaml»

Étant donné que les fichiers se trouvent dans un dossier intégré et non dans un environnement personnalisé, assurez-vous de surveiller votre propre structure des fichiers. Vous pouvez les charger dans différents dossiers, mais dans ce cas, mettez à jour le code du bloc-notes pour trouver correctement le fichier config.yaml .

5. Cliquez sur Exécuter la cellule :

Validation

- Une fois le travail terminé, vérifiez que les données ont bien été copiées dans votre Lakehouse.

- Vérifiez les tables spécifiées et assurez-vous que les données correspondent aux tables Delta partagées.

- Attendez que le travail soit terminé, il devrait copier toutes les données.

Se connecter aux Databricks

Remarque

Cette méthode de connexion est généralement utilisée par les professionnels de la data.- Connectez-vous à votre environnement Databricks.

- Accédez à la section Catalogue .

- Sélectionnez Partage Delta dans le menu supérieur.

- Sélectionnez Partagé avec moi.

- Copiez l’identifiant de partage qui vous a été fourni.

- Partagez l’identifiant de partage avec l’équipe de support Procore.

Remarque : Une fois l’identificateur de partage ajouté au système de Procore, la connexion Procore Databricks s’affiche dans l’onglet Partagé avec moi sous Fournisseurs dans votre environnement Databricks. Cela peut prendre jusqu’à 24 heures pour voir les données.

- Lorsque votre connexion Procore Databricks devient visible dans l’onglet Partagé avec moi , sélectionnez l’indentificateur Procore et cliquez sur Créer un catalogue.

- Entrez le nom que vous préférez pour le catalogue partagé et cliquez sur Créer.

- Votre catalogue et vos tables partagés s’afficheront désormais sous le nom fourni dans la section Explorateur de catalogues.

Veuillez communiquer avec le support Procore si vous avez des questions ou si vous avez besoin d’aide.

Se connecter à Snowflake à l’aide de Python

Aperçu

L’outil Nuage Connect Access de Procore Analytics est une interface de ligne de commande (CLI) qui vous aide à configurer et à gérer les transferts de données de Procore vers Snowflake.

Il se compose de deux composantes principales :

- user_exp.py: Utilitaire de configuration

- ds_to_snowflake.py: Script de synchronisation des données

Conditions préalables

- Python est installé sur votre système

- Accès à Procore Delta Share

- Identifiants du compte Snowflake

- Installez les dépendances requises à l’aide de :

- pip install -r requirements.txt

Étapes

- Configuration initiale

- Synchronisation des données

- Configuration de la source de partage Delta

- Configuration de la cible Snowflake

- Options de planification

- Meilleures pratiques

- Dépannage

Configuration initiale

Exécutez l’utilitaire de configuration à l’aide de python user_exp.py.

Synchronisation des données

Après la configuration, vous avez deux options pour exécuter la synchronisation des données :

- Exécution directe :

- python ds_to_snowflake.py

- Exécution planifiée

- S’il est configuré lors de l’installation, le travail s’exécutera automatiquement selon votre planification Cron.

- Pour vérifier les journaux d’ordonnancement, le fichier 'procore_scheduling.log' sera créé dès que l’échéancier sera configuré.

- En outre, vous pouvez vérifier la planification en exécutant la commande du terminal :

Pour Linux et MacOS :

- Pour modifier/supprimer - modifiez le cron de l’échéancier en utilisant :

'''bash

EDITOR=nano crontab -e

``` - Après avoir exécuté la commande ci-dessus, vous devriez voir quelque chose de similaire à :

2 * * * *

/Utilisateurs/your_user/flocon de neige/venv/bin/python

/Utilisateurs/your_user/flocon de neige/sql_server_python/connection_config.py

2> et 1 | while ligne lue ; do echo « $(date) - $line » ; C’est fait>>

/Utilisateurs/your_user/flocon de neige/sql_server_python/procore_scheduling.log # importation-des-donnees procore - Vous pouvez également ajuster le cron de l’échéancier ou supprimer la ligne entière pour l’empêcher de fonctionner selon l’échéancier.

Pour Windows :

- Vérifiez que la tâche de l’échéancier est créée :

```

PowerShell (en anglais seulement)

schtasks /query /tn « ProcoreDeltaShareScheduling » /fo LIST /v

```

- Pour modifier/supprimer une tâche de planification, ouvrez le planificateur de tâches.

- Appuyez sur Win + R, tapez taskschd.msc, et appuyez sur Entrée.

- Accédez aux tâches planifiées.

- Dans le volet gauche, développez la bibliothèque du planificateur de tâches.

- Recherchez le dossier dans lequel votre tâche est enregistrée :

Exemple : bibliothèque du planificateur de tâches ou dossier personnalisé. - Trouvez votre tâche.

- Recherchez le nom de la tâche : ProcoreDeltaShareScheduling.

- Cliquez dessus pour afficher les détails dans le volet inférieur.

- Vérifiez son échéancier :

- Vérifiez l’onglet Déclencheurs pour voir quand la tâche est définie pour s’exécuter.

- Consultez l’onglet Historique pour confirmer les exécutions récentes.

- Pour supprimer la tâche :

- Supprimer la tâche de l’interface graphique.

Configuration du partage Delta

- Création d’un fichier config.share

- Avant d’exécuter l’utilitaire de configuration, vous devez créer un fichier config.share avec vos informations d’identification Delta Share. Le fichier doit être au format JSON :

{

« shareCredentialsVersion » : 1,

« bearerToken » : « xxxxxxxxxxxxx »,

« endpoint » : « https://nvirginia.nuage. databricks.c... astores/xxxxxx"

}

- Champs obligatoires :

- ShareCredentialsVersion : numéro de version (actuellement 1).

- BearerToken : votre jeton d’accès Delta Share.

- Point de terminaison : URL de votre point de terminaison Delta Share.

- Ces détails peuvent être obtenus à partir de l’interface utilisateur Web de Procore.

- Étapes pour créer config.share :

- Créez un nouveau fichier nommé config.share.

- Copiez le modèle JSON ci-dessus.

- Remplacez les valeurs d’espace réservé par vos informations d’identification réelles.

- Enregistrez le fichier dans un emplacement sûr.

- Vous devrez fournir le chemin d’accès à ce fichier lors de la configuration. Lors de la configuration de la source de données, il vous sera demandé de fournir les informations suivantes :

- Liste des tableaux (séparés par des virgules).

- Laisser en blanc pour synchroniser tous les tableaux.

- Exemple : table1, table2, table3.

- Chemin d’accès à votre fichier config.share .

Configuration du flocon de neige

Vous devrez fournir les informations suivantes sur le flocon de neige :

- Authentification (choisissez-en une) :

- Authentification de l’utilisateur

- Nom d’utilisateur

- Mot de passe (saisi en toute sécurité)

- Authentification de l’utilisateur

- Authentification par paire de clés

- Nom d’utilisateur

- Chemin d’accès au fichier de clé privée

- Mot de passe du fichier de clé privée

- Détails de connexion :

- Identifiant de compte

- Nom de l’entrepôt

- Nom de la base de données

- Nom du schéma

- Nombre de threads simultanés

Options de planification

L’outil offre la possibilité de planifier une synchronisation automatique des données.

- Configuration de la tâche Cron

- Choisir de configurer ou non une tâche quotidienne

- Si oui, fournissez un échéancier cron

- Format : * * * * * (minute, heure, jour-de-mois, mois, jour de la semaine)

- Exemple pour tous les jours à 2 heures du matin : 0 2 * * *

- Exécution immédiate

- Possibilité d’exécuter le ds_to_snowflake.py immédiatement après la configuration

- Structure des fichiers

Non défini

├── requirements.txt # Dépendances

├── user_exp.py # Utilitaire de configuration

├── ds_to_snowflake.py # Script de synchronisation des données

├── config.yaml # Configuration générée

├── config.share # Fichier de configuration Delta Share

├── procore_scheduling.log # Journal des exécutions d’ordonnancement

Exemple d’utilisation- Étape 1: Installer les dépendances

$ pip install -r requirements.txt - Étape 2: Exécuter l’utilitaire de configuration

$ python user_exp.py - Accès à Nuage Connect de Procore Analytics

- Cette interface de ligne de commande vous aidera à choisir votre magasin source et votre magasin de destination pour accéder aux données Procore et les écrire dans Snowflake.

- Appuyez sur Entrée pour continuer.

- Entrez la liste des tableaux (séparés par des virgules), laissez-la vide pour tous les tableaux : projets, utilisateurs, tâches.

- Entrez le chemin d’accès au fichier config.share : /chemin/vers/config.share.

- Entrez le nom d’utilisateur : snowflake_user.

- Quel type d’authentification souhaitez-vous utiliser ? (user/key_pair) : Entrée.

- 1 pour l’utilisateur,

- 2 pour la paire de clés :

- 1

- Entrez le mot de passe : ********

- Saisir le compte : my_account

- Entrez dans l’entrepôt : my_warehouse

- Entrez le nom de la base de données : procore_db

- Entrez le nom du schéma : procore_schema

- Entrez le nombre de threads : 4

- Voulez-vous configurer cela comme un travail quotidien sur cron ? (Oui/Non) : Oui

- Saisir l’échéancier au format cron (p. ex. * * * * * ) : 0 2 * * *

- Voulez-vous exécuter le travail maintenant ? (Oui/Non) : Oui

- Étape 3: Exécution manuelle (si nécessaire)

$ python ds_to_snowflake.py

- Étape 1: Installer les dépendances

- Réutilisation de la configuration

L’outil enregistre votre configuration dans le fichier config.yaml et vous propose de réutiliser les paramètres précédemment stockés :- La configuration de la source peut être réutilisée.

- La configuration de la cible (Snowflake) peut être réutilisée.

- Vous pouvez choisir de mettre à jour l’une ou l’autre configuration indépendamment.

Meilleures pratiques

- Authentification

- Utilisez l’authentification par paire de clés lorsque cela est possible.

- Faites régulièrement une rotation des informations d’identification.

- Utilisez les autorisations minimales requises.

- Performances

- Ajustez le nombre de threads en fonction des capacités de votre système.